還記得之前那個提出了新的液體基礎模型(LFM,Liquid Foundation Model)的 Liquid AI 嗎?在被 AMD 投資數月后,這家來自美國麻省理工學院的初創公司又帶來新成果了。

4 月 25 日,Liquid AI 正式發布了面向邊緣設備的全新 AI 架構“Hyena Edge”。與目前主流的基于 Transformer 的模型架構不同,Hyena Edge 是一種基于卷積的多混合模型,專為智能手機等邊緣設備優化設計。

“人工智能正迅速變得無處不在,從大規模云端部署到智能手機和筆記本電腦等資源受限的邊緣設備。”Liquid AI 科學團隊成員 Armin Thomas、Stefano Massaroli 和 Michael Poli 在研究報告中表示,“盡管有令人印象深刻的進步,大多數為邊緣部署優化的小型模型,如 SmolLM2、Phi 模型和 Llama 3.2 1B,主要依賴于基于注意力運算符的 Transformer 架構。”

這些傳統架構雖然具有可并行計算和高效內核的特點,但在邊緣設備上仍面臨效率瓶頸。而 Hyena Edge 作為一種 Liquid 架構,天生就在計算效率上具有優勢,非常適用于邊緣部署。據 Liquid AI 宣稱,Hyena Edge 在真實硬件測試中,于計算效率和模型質量兩方面均展現出超越 Transformer 基線的性能。

他們在三星 Galaxy S24 Ultra 上對 Hyena Edge 進行了測試,結果顯示該模型在多個關鍵指標上均超越強大的基于 Transformer 的基準模型。

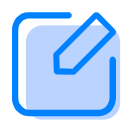

在效率方面,Hyena Edge 展示了更快的預填充(prefill)和解碼延遲。特別是對于超過 256 個標記的序列,解碼和預填充延遲最高可提高 30%。值得注意的是,其在短序列長度下的預填充延遲也優于 Transformer 基線,這一點對響應式設備應用至關重要。在內存使用方面,Hyena Edge 在所有測試序列長度下均使用更少的內存。

圖丨在三星 S24 Ultra 智能手機上收集的延遲和內存配置文件(來源:Liquid AI)

在模型質量方面,Hyena Edge 在經過 1000 億 tokens 的訓練后,在包括 Wikitext、Lambada、Hellaswag、Winogrande、Piqa、Arc-easy 和 Arc-challenge 在內的各種常見語言建模基準測試中表現出色。例如,在 Wikitext 上的困惑度(perplexity)從 17.3 降至 16.2,在 Lambada 上從 10.8 降至 9.4,在 PiQA 上的準確率從 71.1% 提升至 72.3%,在 Hellaswag 上從 49.3% 提升至 52.8%,在 Winogrande 上從 51.4% 提升至 54.8%。

“這些結果表明,模型的效率提升并不以預測質量為代價——這是許多邊緣優化架構常見的取舍。”研究團隊表示。

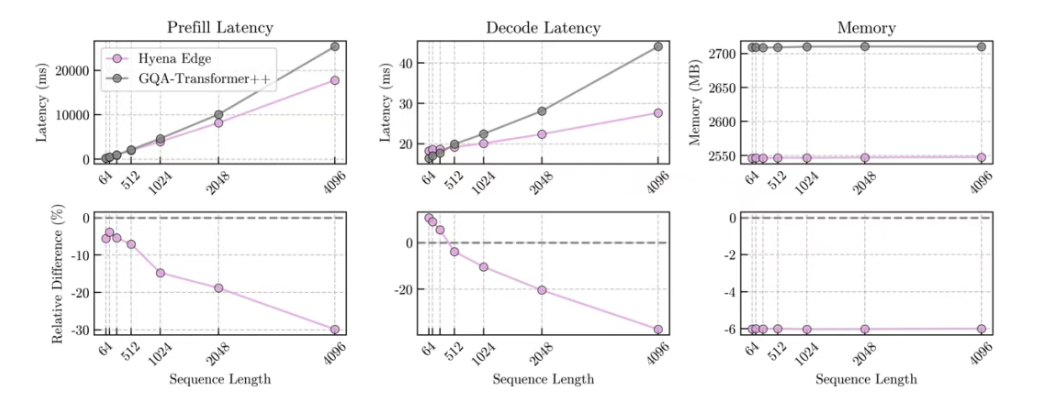

而 Hyena Edge 的核心技術,正在于團隊此前提出的 STAR(Synthesis of Tailored Architectures)框架及其優化技術。STAR 框架的核心思想是利用進化算法(Evolutionary Algorithms)和線性輸入變化系統(LIVs,Linear Input-Varying Systems)的數學理論,來高效地探索廣闊的神經網絡架構空間,并自動合成出針對特定目標(如低延遲、小內存占用、高模型質量、小參數量等,可多目標同時優化)的“量身定制”的架構。

圖丨 STAR 框架說明(來源:Liquid AI)

與傳統的依賴人工經驗和直覺進行模型設計,或在有限空間內進行自動化搜索的方法不同,STAR 提供了一個更全面的解決方案。LIV 理論是一個關鍵的理論基礎,它能夠統一地描述和泛化深度學習中常見的多種計算單元,包括各種注意力變體、線性循環網絡、卷積網絡以及其他結構化算子。STAR 基于 LIV 理論,構建了一個新穎的、分層的架構搜索空間。

在這個框架下,模型架構被編碼成一種“基因組(Genome)”。這種基因組包含了架構的多個層級信息,從底層的特征化(Featurization)方式、算子結構(Operator Structure,定義了 Token 和 Channel 的混合方式),到頂層的骨干網絡(Backbone,定義了 LIV 單元之間的連接和組合方式)。STAR 的基因組設計具有良好的層次化和模塊化特性。

隨后,STAR 運用進化算法的原理,對這些架構基因組進行迭代優化。主要包括評估(根據預設目標衡量架構性能)、重組(組合優秀父代架構的特征)和變異(引入隨機變化以探索新架構)等步驟。該框架支持多目標優化,能夠同時考慮模型質量、參數量、推理緩存大小、延遲等多個可能相互沖突的指標,以尋找在這些目標間達到較好平衡的架構方案。

根據其技術文檔,STAR 在優化大型語言模型架構時,無論是在純質量優化、質量與參數量聯合優化,還是質量與推理緩存大小聯合優化方面,其生成的架構均能在各項指標上顯著優于高度優化的 Transformer++ 和 StripedMamba 等基準模型。例如,在優化質量和參數量時,7/8 的 STAR 進化架構在下游任務基準上超越了 Transformer++ 和混合模型,同時參數量減少高達 13%。在優化質量和緩存大小時,7/8 的 STAR 進化架構實現了比混合模型小 37%、比 Transformer 小 90% 的緩存,同時質量相當甚至更好。

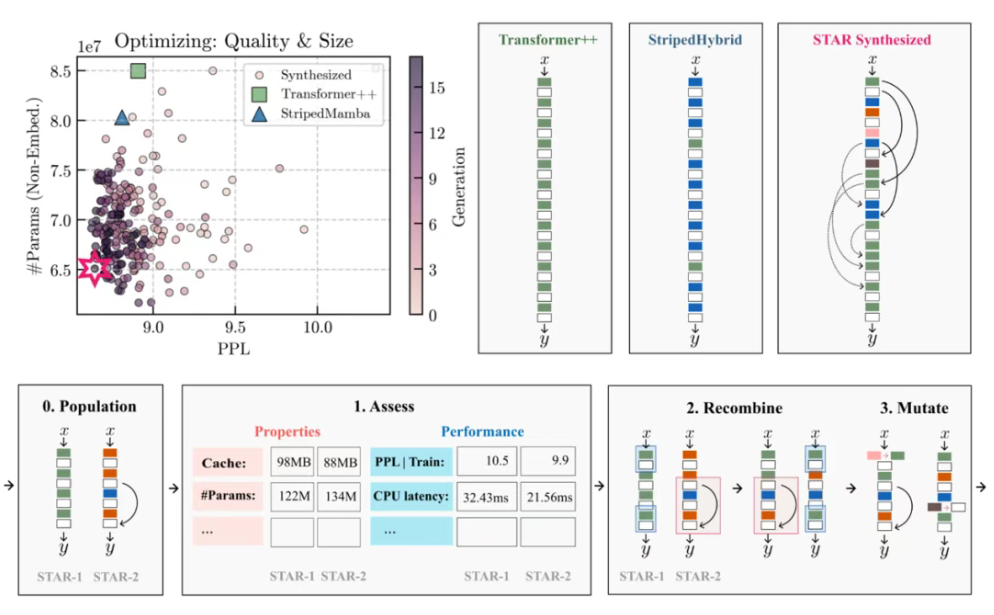

在 Hyena Edge 的設計中,Liquid AI 團隊就應用了 STAR 框架。他們從一個包含 16 個候選架構的初始種群開始,進行了 24 代的進化迭代。其搜索空間設計得非常豐富,包含了多種卷積算子的變體,這些變體主要受到 Hyena 架構的啟發:

· Hyena(Full):在門控機制(Gating Mechanism)和 Hyena 內部卷積中都包含卷積操作。

· Hyena-X:排除了內部卷積。

· Hyena-Y:排除了特征組(門)中的卷積。

除了這三種主要的 Hyena 類型,搜索空間還考慮了它們學習到的短距離、顯式卷積核的長度變化(從 3 到 128),總共構成了 18 種不同的卷積算子。此外,搜索空間還包括了分組查詢注意力的變體(具有不同的 KV 頭數量)和 SwiGLU(具有不同的內部寬度)等常見的 Transformer 組件。

在進化過程中,STAR 框架通過對每個候選架構在三星 S24 Ultra 上的初始延遲和內存占用進行性能分析,并結合模型在訓練過程中的困惑度表現,不斷地將架構種群向著效率-質量前沿(Efficiency-Quality Frontier)進行優化。

完整視頻鏈接:https://mp.weixin.qq.com/s/BMHlOghJgBjou_yJuuZjXg

有意思的是,隨著進化過程的推進,當架構接近效率-質量最優邊界時,STAR 明顯地偏愛選用 Hyena-Y 類型的卷積。這表明 Hyena-Y 卷積在延遲、內存和模型質量之間取得了更優越的平衡。

基于這一發現,最終的 Hyena Edge 架構在一個 GQA-Transformer++ 基準模型的基礎上,將部分 GQA 算子替換為由 STAR 優化選出的 Hyena-Y 門控卷積。

而最終結果如基準測試所表明的,Hyena Edge 在提升效率的同時,保持了較高的模型質量,這對于性能和資源都受限的邊緣設備應用而言是一個重要的特性。

Liquid AI 已表示計劃在未來數月內開源包括 Hyena Edge 在內的一系列基礎模型,其目標是構建能夠適應從云端到邊緣多種環境的 AI 系統。除了模型本身,其所展現出的設計方法,或許更值得我們的期待。

參考資料:

1. https://www.liquid.ai/research/convolutional-multi-hybrids-for-edge-devices

2.https://arxiv.org/abs/2411.17800

來源:DeepTech深科技

資訊頻道

資訊頻道